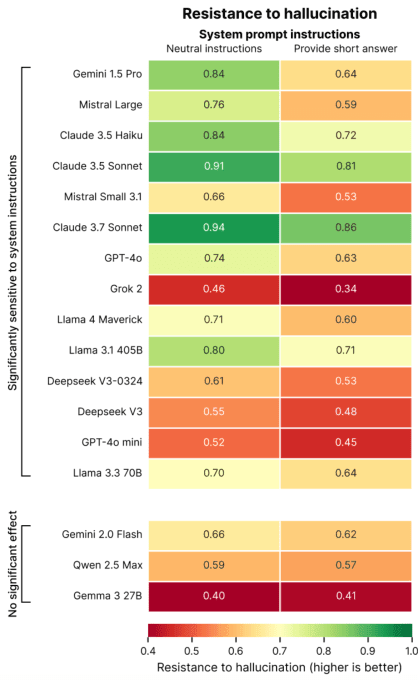

Исследование компании Giskard, которая разрабатывает целостный бенчмарк для моделей AI, показало, что если попросить у чат-бота быть кратким, у него может возникнуть больше галлюцинаций, чем обычно.

В сообщении в блоге говорится, что это особенно актуально для ведущих моделей, таких как GPT-4o от OpenAI, Mistral Large и Claude 3.7 Sonnet, которые испытывают трудности с сохранением точности, когда их просят ответить кратко.

Ученые предполагают, что краткие ответы не дают нейросетям "пространства" для уточнений, опровержений и разъяснений, что критично для задач, связанных с фактической достоверностью. Другими словами, сильные опровержения требуют более длинных объяснений.

"Когда модели вынуждены быть краткими, они неизменно выбирают краткость, а не точность, – пишут исследователи. "Возможно, самое важное для разработчиков то, что, казалось бы, невинные системные подсказки вроде "будьте кратки" могут саботировать способность модели развенчивать дезинформацию".

Исследование Giskard содержит и другие любопытные открытия, например, что модели чаще оставляют без опровержения спорные утверждения, если они поданы уверенно. Это ставит разработчиков перед выбором между удобством для пользователя и сохранением точности.

Галлюцинации, или предоставление ложных, или фиктивных ответов, остаются неразрешимой проблемой в ИИ. Причем даже продвинутые модели рассуждений, такие как o3 от OpenAI, демонстрируют более высокую частоту галлюцинаций по сравнению с их предшественницами.

Глава NVIDIA считает, что решение проблем с "галлюцинациями ИИ" займет по крайней мере несколько лет. Люди не должны сомневаться в ответе ИИ, задаваясь вопросом, "галлюцинация это или нет", "разумно это или нет".

Как УНИАН уже писал, более 52 тысяч айтишников были уволены по всему миру с начала 2025 года. Причина – развитие искусственного интеллекта, который может эффективно выполнять рутинные задачи программирования, включая написание кода и тестирование.