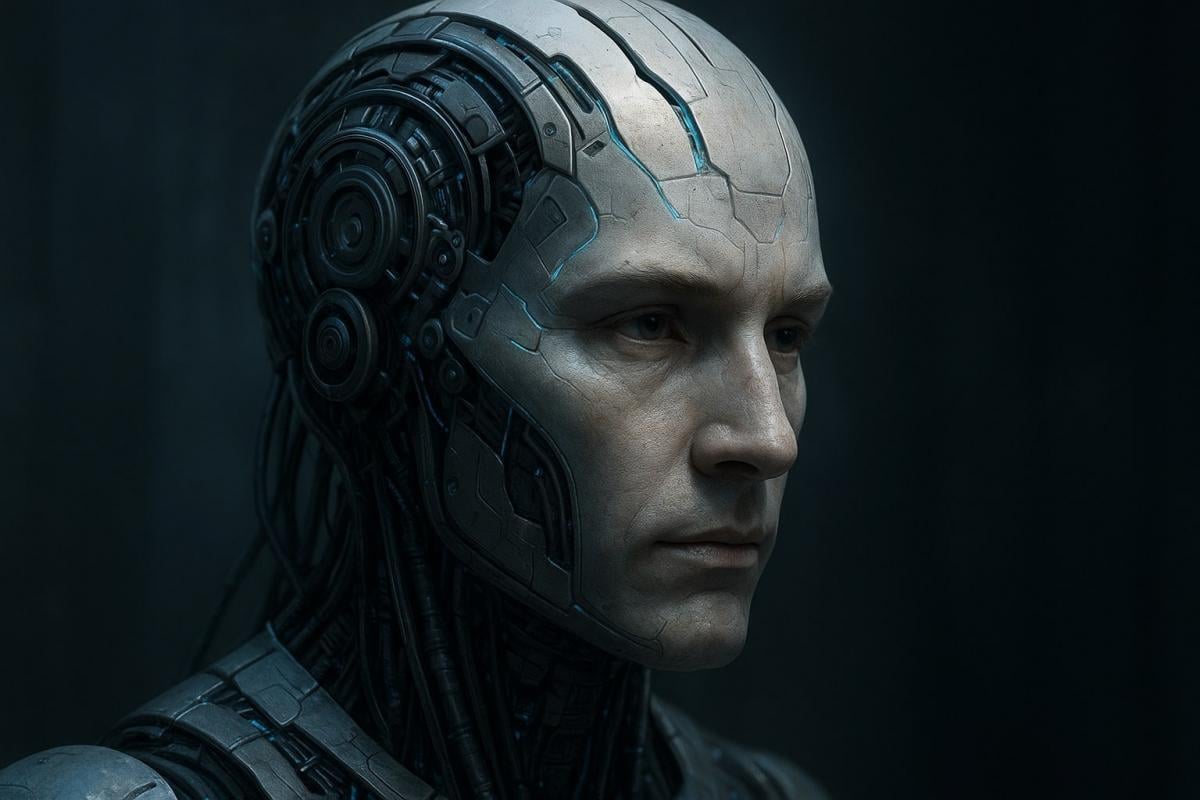

Пока вы используете ИИ-инструменты вроде ChatGPT или Google Gemini для написания писем, генерации фото и автоматизации задач, гонка за создание искусственного общего интеллекта (AGI) уже набирает обороты. Однако CEO крупных технологических компаний, таких как Марк Цукерберг из Meta и Илон Маск из Tesla, нацелены на нечто более амбициозное – искусственный сверхинтеллект (ASI).

Разница между AI, AGI и ASI

Все эти термины звучат похоже, но обозначают совершенно разные уровни возможностей.

AI (узкий искусственный интеллект): выполняет конкретные задачи, например, генерацию текста или фотографий и требует человеческого вмешательства.

AGI (искусственный общий интеллект): машины смогут мыслить, учиться, принимать решения и решать проблемы без специальной подготовки для каждой задачи.

ASI (искусственный сверхинтеллект): выходит за пределы человеческих возможностей, будет принимать решения самостоятельно и совершенствоваться без участия человека

Что именно представляет собой искусственный сверхинтеллект

Сверхинтеллект – это гипотетическая система превосходящая человеческий интеллект во всем. От написания кода и генерации видео до проведения сложных хирургических операций и вождения автомобилей, она будет делать все одновременно, чего не хватает современным системам ИИ.

Философ Ник Бостром, популяризировавший термин, определяет сверхинтеллект как "любой интеллект, который значительно превосходит человеческие когнитивные способности человека практически во всех интересующих нас областях".

Современные системы ИИ нуждаются в людях для их совершенствования: инженеры работают над кодом, "скармливая" моделям огромные объемы данных для улучшения их прогнозов и ответов. Сверхинтеллект, с другой стороны, может совершенствоваться сам. Теоретически он мог бы переписывать собственные алгоритмы, конструктивные решения и системы управления без инструкций.

Когда появится ASI и стоит ли нам его бояться

Точной уверенности, что сверхинтеллект возможен, нет. Однако если машины станут умнее людей и смогут самостоятельно развиваться, AI может выйти из-под контроля, если не быть осторожным. Некоторые эксперты предсказывают появление сверхинтеллекта в течение десятилетия, а инвесторы вливают миллиарды долларов в компании, стремящиеся его создать.

В 2023-м году соучредители OpenAI Грег Брокман и Илья Суцкевер, а также гендиректор Сэм Альтман призвали к созданию международного регулятора, чтобы сверхинтеллект не захватил человечество. Интересно, что в 2024 году Суцкевер покинул OpenAI и основал стартап, ориентированный на создание безопасного суперинтеллекта.

Хотя считается, что люди смогут достичь большего и решать сложные задачи с помощью сверхинтеллекта, так как он может стать последним изобретением, которое потребуется сделать человеку, риски превышают возможные плюсы.

Угроза рабочим местам: AI уже заменяет людей во многих профессиях, а ASI может привести к исчезновению целых отраслей.

Экзистенциальные риски: если машины начнут мыслить самостоятельно и управлять системами, это может угрожать всему человечеству – от угроз национальной безопасности до потенциального вымирания.

В октябре 2025 года более 850 экспертов по искусственному интеллекту, включая Стива Возняка, Демиса Хассабиса, Дарио Амодеи, Геофри Хинтона и Йошуа Бенджио, подписали открытое заявление с призывом остановить разработку сверхинтеллекта, пока не будет гарантий его безопасного внедрения.

А глава OpenAI Сэм Альтман недавно выcтупил заявлением, что ИИ заменит "не настоящую работу". Новая технология покажет, какие виды на самом деле действительно создают ценность, а какие – лишь имитируют труд. Заявление Альтмана вызвало критику и оживленные споры в сети.