Хотя искусственный интеллект уже давно обгоняет людей в скорости обработки данных и точности вычислений, его логическое мышление по-прежнему оставляет желать лучшего.

Новый тест ARC-AG2 наглядно демонстрирует, что даже самые мощные модели ИИ не способны решать задачи, которые для человека кажутся элементарными.

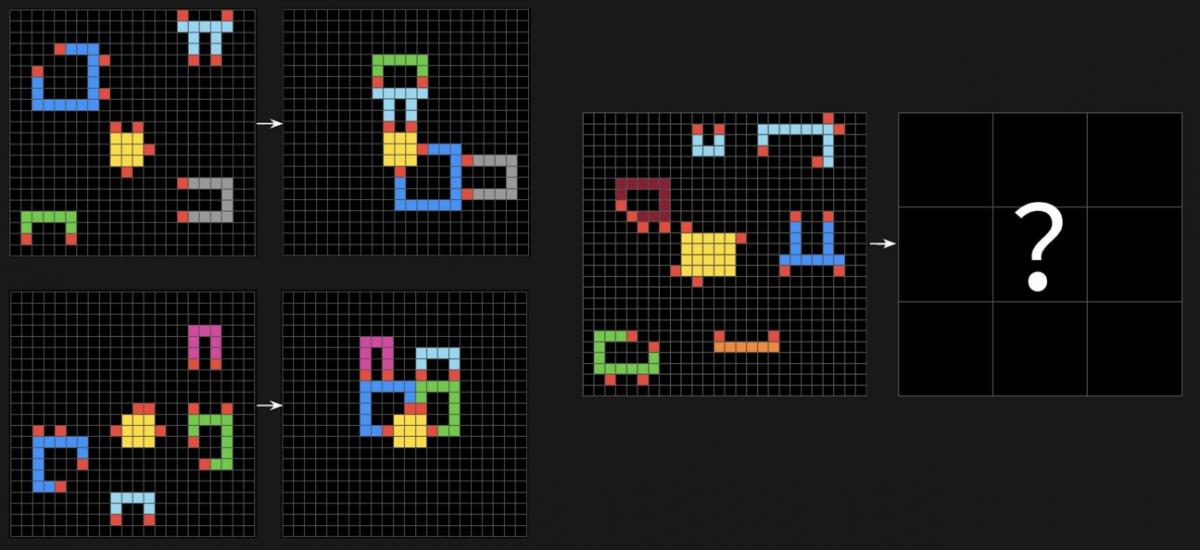

ARC-AG2 (Abstraction and Reasoning Corpus) - это серия логических задач, где ИИ необходимо определить закономерность в последовательности разноцветных квадратов и выбрать правильный ответ. Такие головоломки невозможно решить методом запоминания, они требуют гибкости мышления, способности к обобщению и переносу знаний на новые задачи.

Результаты теста показывают, что ИИ пока не обладает этими навыками:

- Deepseek R1 набрал всего 1,3% правильных ответов

- Google Gemini и Claude 3.7 Sonnet показали около 1%,

- GPT-4.5 от OpenAI справился ещё хуже - 0,8%.

Разработчики ARC-AG2 намеренно сделали задачи сложными для искусственного интеллекта, но простыми для человека. В отличие от традиционных тестов, где ИИ может опираться на огромные базы данных, здесь ему приходится адаптироваться к новой информации на ходу - и это его слабое место.

Предыдущая версия теста, ARC-AG1, была создана в 2019 году и оставалась нерешаемой для ИИ на протяжении четырёх лет. Если новая версия окажется столь же сложной, это может значительно замедлить прогресс в разработке искусственного общего интеллекта (AGI).

Но не всё так плохо с развитием ИИ. Ранее мы рассказывали, что ИИ-инструмент Google за два дня смог решить научную проблему устойчивости некоторых супербактерий к антибиотикам, которая ежегодно уносит миллионы жизней.